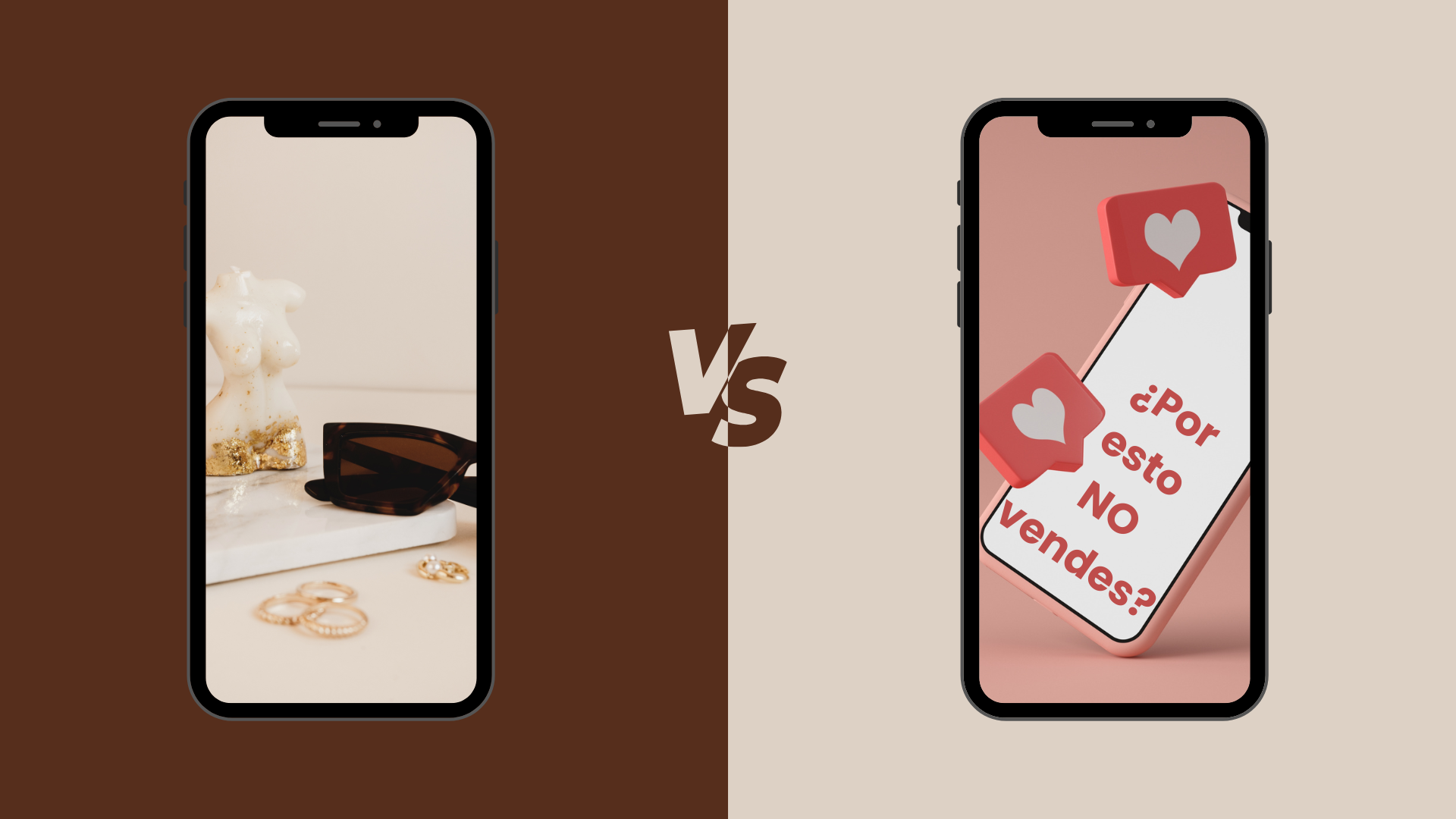

Por qué los reels “bonitos” ya no convierten: estética vs intención en marketing digital

Durante años, crear contenido para redes sociales parecía tener una única regla: cuanto más bonito, mejor. Buena iluminación, tipografías cuidadas, colores armónicos, transiciones suaves y música en tendencia. Y durante un tiempo esto ha funcionado, sin embargo, a día de hoy muchas marcas se enfrentan a la misma frustración, los reels se ven profesionales, reciben visualizaciones… pero no convierten. Entonces, la pregunta es ¿qué está fallando?, pues en definitiva la estética ha dejado de ser diferencial y ha pasado a ser simplemente el punto de partida. Vamos a analizar punto a punto la estética vs intención en marketing digital. Cuando “lo bonito” dejó de ser suficiente La democratización de las herramientas de diseño ha cambiado por completo el escenario. Hoy cualquier persona puede crear contenido visualmente atractivo gracias a: Esto ha provocado que la calidad visual media haya subido, pero también que lo estético haya perdido su poder de diferenciación. El usuario ya no se detiene porque algo sea bonito. Se detiene porque algo conecta con él. El error más común: confundir impacto visual con impacto real Un reel puede cumplir con todos los estándares estéticos y aun así no generar resultados reales. ¿Por qué?, no todo el contenido que vemos cumple una función clara, ya que muchos reels están diseñados para: mostrar lo bien que trabaja una marca, reforzar una identidad visual o enseñar un producto de forma atractiva. Por otro lado, muy pocos se centran en que problema resuelven con su contenido, que debería sentir la persona que lo ve o porque alguien debería guardar, comentar o volver al vídeo. Sin intención, el contenido se consume… y se olvida. Estética sin intención: el gran vacío del contenido actual Las personas no entran a redes sociales para admirar marcas. Entran para resolver micro problemas, aunque sea de forma inconsciente. Buscan entender por qué algo no les funciona, aprender algo rápido, sentirse identificadas, evitar errores o tomar mejores decisiones en su día a día. Cuando un reel no parte de una necesidad real del usuario, se queda en la superficie. Puede resultar agradable de ver y encajar visualmente con una marca, pero no genera impacto real. No se guarda, no se comenta y no impulsa ninguna acción. Es contenido que se consume en segundos y se olvida con la misma rapidez, porque no aporta valor más allá de lo estético. Qué tienen en común los reels que sí convierten Los reels que funcionan hoy no suelen ser los más producidos ni los visualmente más complejos, sino los más claros y estratégicos. Son piezas de contenido pensadas con un objetivo concreto y construidas desde la comprensión real del usuario, no desde la estética o el lucimiento de la marca. Estos reels comparten una intención bien definida: un solo mensaje, una sola idea y un único problema a tratar. No intentan abarcarlo todo ni condensar demasiada información en pocos segundos. Saben que la claridad es mucho más efectiva que la sobrecarga de contenido. Además, hablan desde el punto de vista del usuario. No se centran en lo que la marca quiere decir, ni en demostrar lo bien que hace las cosas, sino en conectar con lo que la persona piensa, siente o vive en su día a día. Esa identificación es lo que hace que el contenido resulte relevante y memorable. Otro elemento clave es que enganchan desde el primer segundo. No empiezan buscando ser estéticamente atractivos, sino interesantes. Lo hacen a través de una pregunta directa, una afirmación incómoda o una verdad reconocible que interpela al espectador y le hace quedarse. Por último, los reels que convierten siempre proponen una acción coherente. No necesariamente vender. A veces el objetivo es que el usuario guarde el contenido, reflexione, comente o cambie una percepción. Pero en todos los casos existe un siguiente paso claro que da sentido al contenido y evita que se quede en un simple consumo pasivo. El nuevo rol de la estética en redes sociales La estética sigue siendo un elemento importante en redes sociales, pero ya no lidera la estrategia de contenido. Su papel ha cambiado: ahora debe acompañar al mensaje, no sustituirlo. En el contexto actual, el orden de prioridades es claro: primero la intención, después el mensaje, seguido de la emoción y, finalmente, la estética. Cuando este equilibrio se respeta, el contenido conecta, se recuerda y genera acción. Sin embargo, cuando el orden se invierte y lo visual se antepone a todo lo demás, el resultado suele ser un contenido espectacular a nivel estético, pero irrelevante en términos de engagement y resultados reales. Para saber por qué los reels “bonitos” ya no convierten: estética vs intención en marketing digital. Antes de subir tu próximo contenido, hazte esta pregunta: “Si alguien ve este reel sin conocer mi marca,¿se va a sentir identificado o solo va a pensar que es bonito?” Si la respuesta es únicamente estética, no estás creando contenido pensado para convertir.